解决 Deepseek 官网卡顿与联网问题的全攻略

相关链接:

本文内容来源于我近期的视频讲解,旨在帮助那些刚入门或遇到类似问题的朋友。从如何处理 Deepseek R1 的联网问题,到免费 API 平台的推荐,再到 Docker 部署美化版 UI 的实践方案,下面我们将逐一展开说明。

一、Deepseek 官网卡顿问题

许多新手反馈 Deepseek 官网访问时出现卡顿现象。可以看下前几天发的这篇文章:文章回顾

二、Deepseek R1 的联网功能 科普

有不少朋友问如何让 Deepseek R1 模型”联网”。这里需要区分两个概念:

- 模型本身:Deepseek R1 是一个离线的语言模型,其预训练数据截止到某个时间点,不具备自动联网更新的能力。

- 平台提供的联网功能:官网或第三方平台集成了额外的联网模块。当用户手动开启联网开关时,平台会调用网络搜索接口,将最新信息补充进回答中。

因此,如果你希望获得最新信息,请确保使用的平台或 API 集成了联网模块。而针对此问题,我将推荐几个优质且快速的 方案 供大家参考。

三、推荐免费且便捷的在线平台

针对不同需求,我列出了以下两款我测试一周的平台,方便大家直接使用:

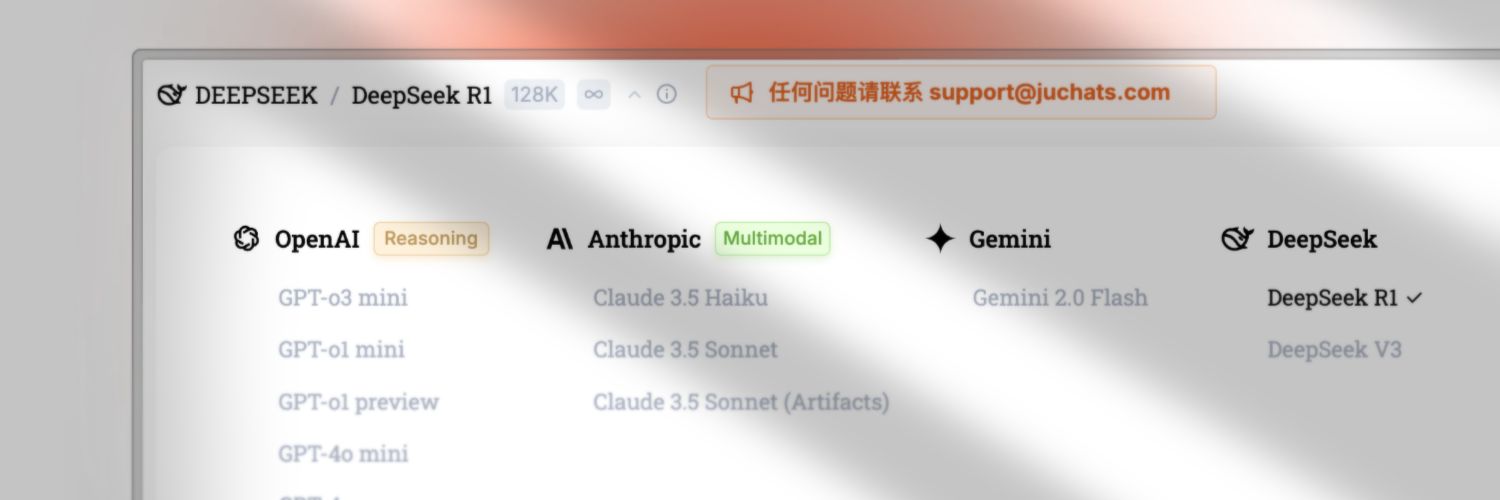

1. Cydiar C佬的 Juchats 平台

该平台最近已接入 Deepseek R1 以及 V3 的满血版,注册登录后即可直接无限使用,伟大无需多言。同时支持 Deepseek R1 模型联网功能。

注意: 博客中的链接均带有邀请码,如果你不希望使用邀请码,请在地址栏中删除相关内容后再加载页面。

2. Flowith.io

支持 Google 或 GitHub 账号直接登录,也可通过邮箱注册。免费用户拥有 5000 次聊天额度,500K 知识库 Token 邀请新人后还能获得更多使用次数。

我的邀请码为:WN57ND ,点击访问按钮后会自动复制到你的粘贴板。

点击访问

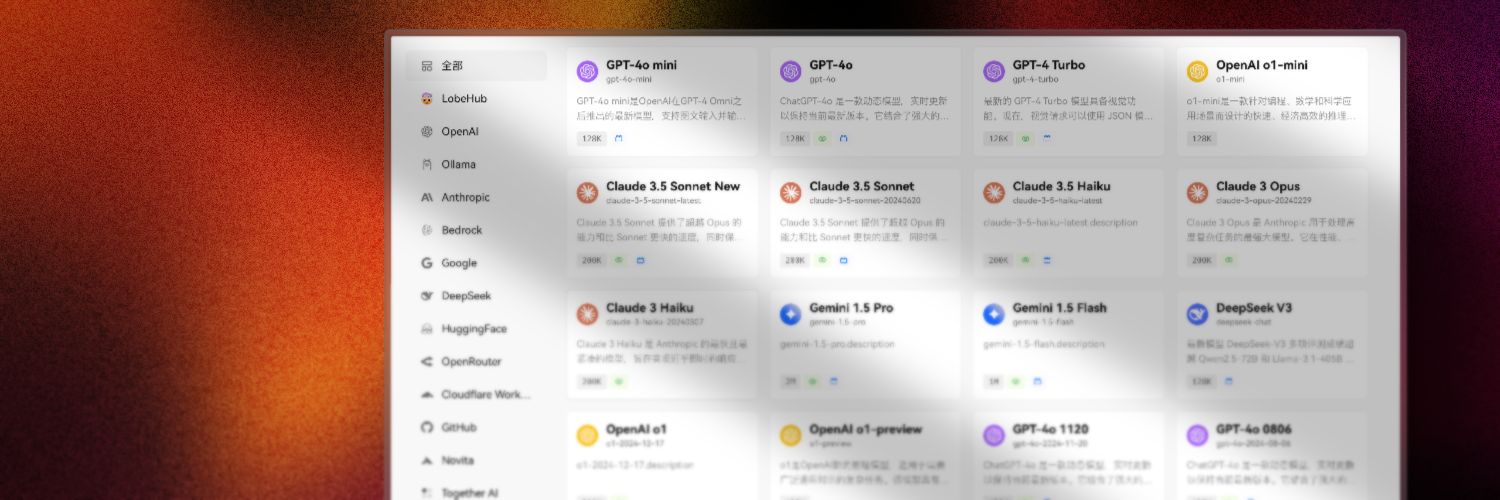

3. LobeChat Cloud

LobeChat Cloud 开始公测: 为所有注册用户提供了免费的 450,000 额度计算积分,无需复杂配置开箱即用, 支持全局云同步与进阶联网查询,更多高级特性等你探索。

4. 微信搜索内置 DeepSeek R1满血版

- 点击顶部的搜索,找到 AI搜索 ,选择 DeepSeek R1 即可开始聊天✨

5. 腾讯元宝 AI 内置 DeepSeek R1满血版

毕竟和微信都属于腾讯公司,所以用同一个源也非常合理,一样支持联网,选择 DeepSeek R1 即可开始聊天✨

四、满血版本地、 API 联网平台推荐

字节跳动旗下火山引擎

火山引擎平台提供 Deepseek-R1 与 Deepseek-V3 满血版的 API 服务,配置稍显复杂但功能强大。

配置 API 及联网功能

进入火山引擎的控制台

点击访问 可使用抖音账号或手机号登录,首次登录后平台会赠送每个模型 50 万 token

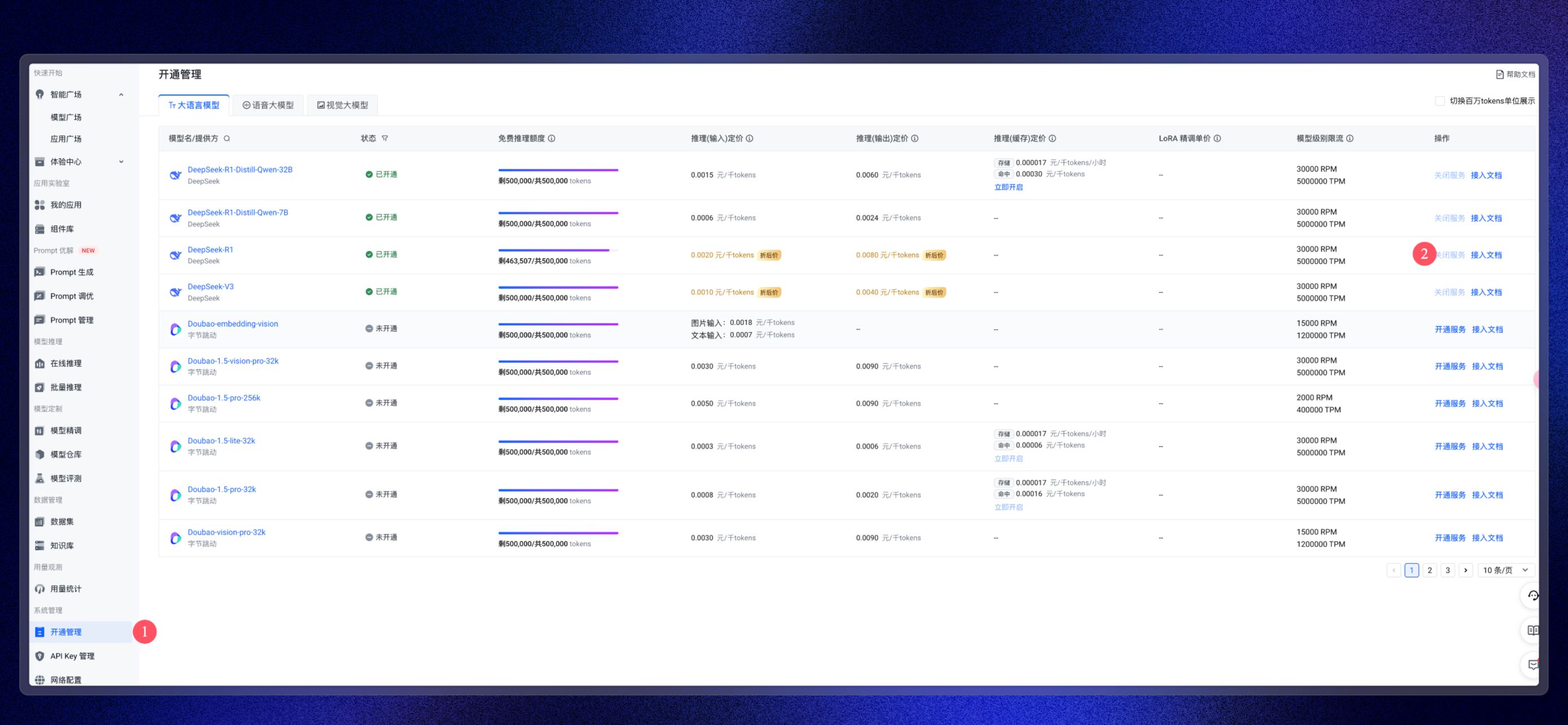

登陆后在左下角点击开通管理,然后在右边列表中开通你要使用的模型(如果已开通请忽略这步)

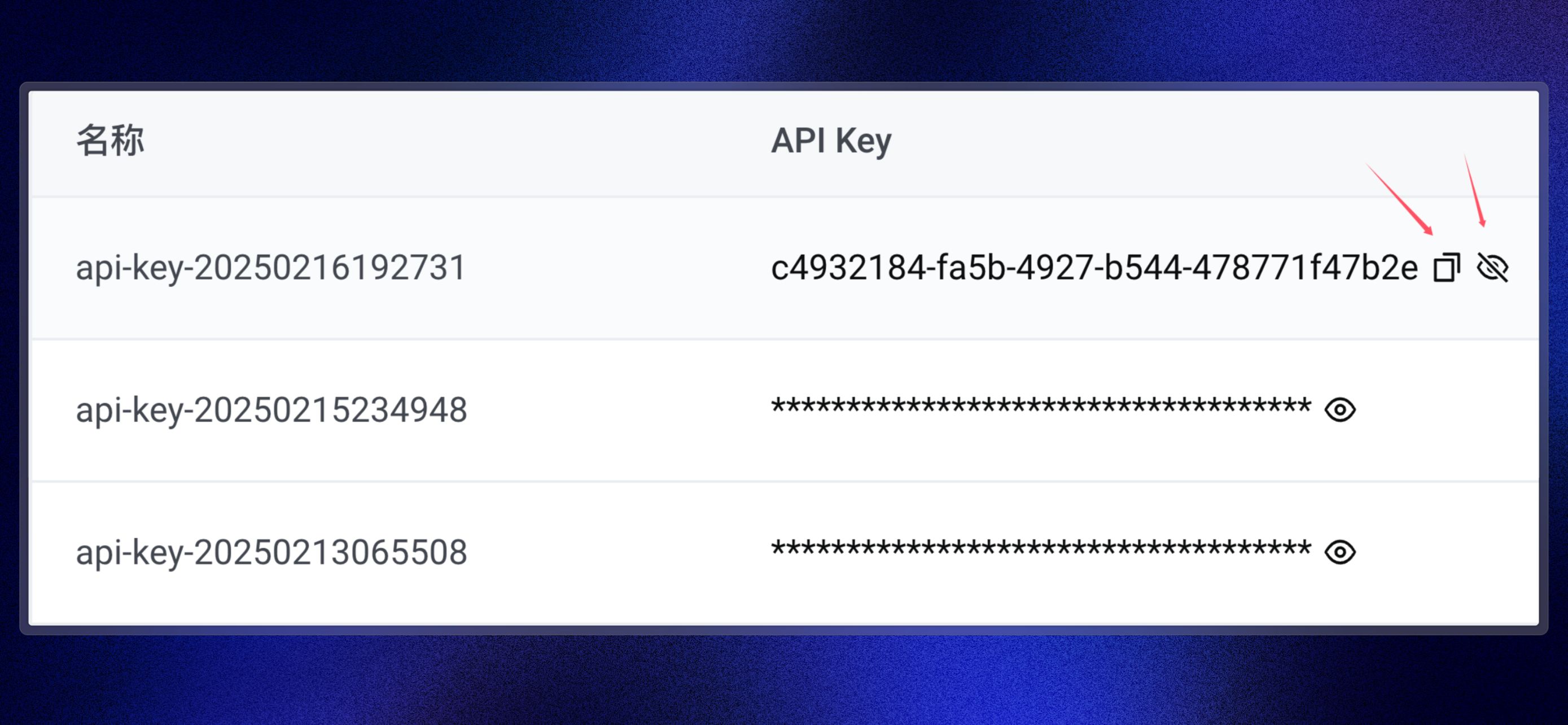

然后再 API Key 管理,在右边创建一个新的 API Key

创建完成后,打开小眼睛图标👀,把 API Key 复制下来

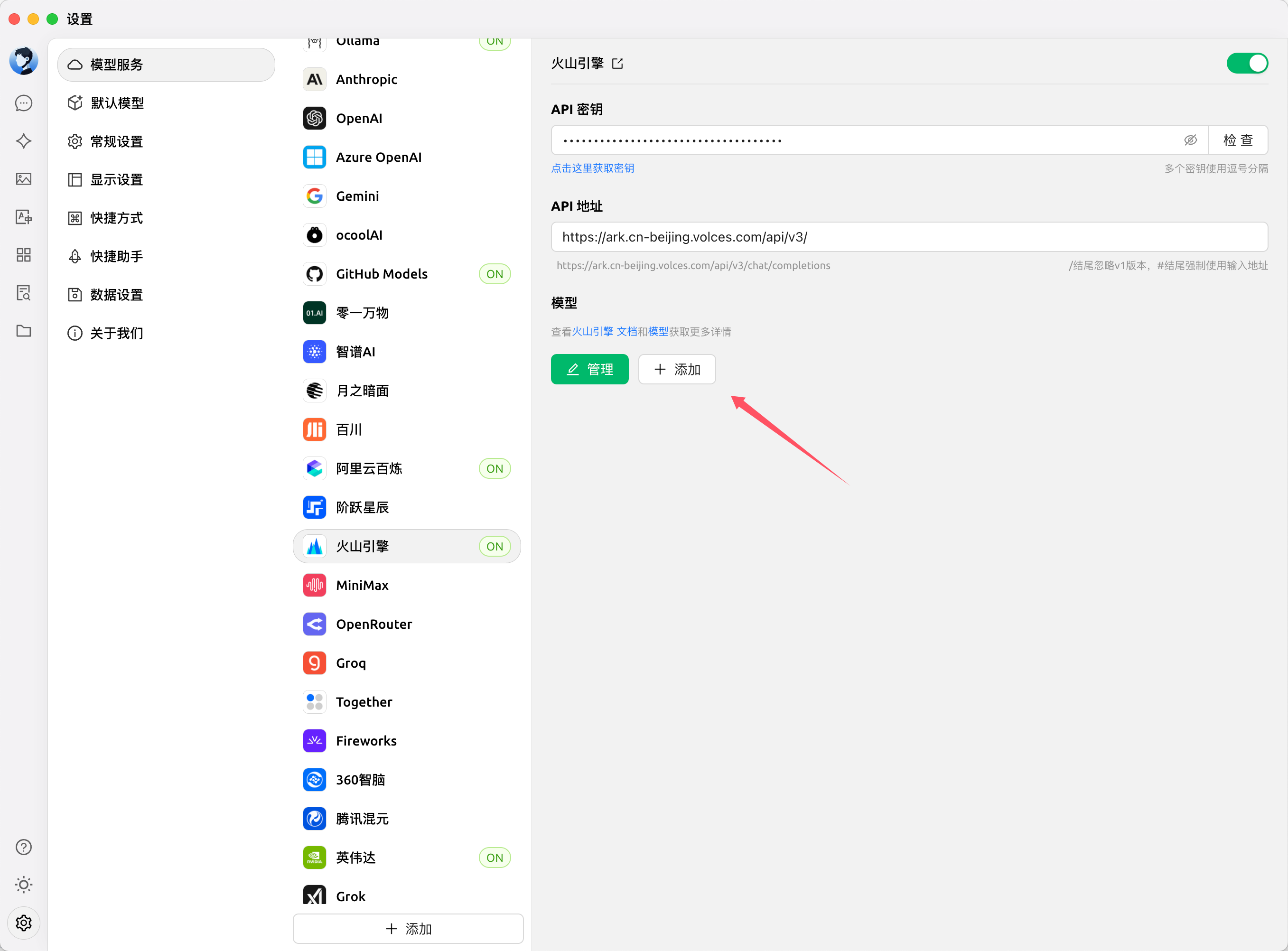

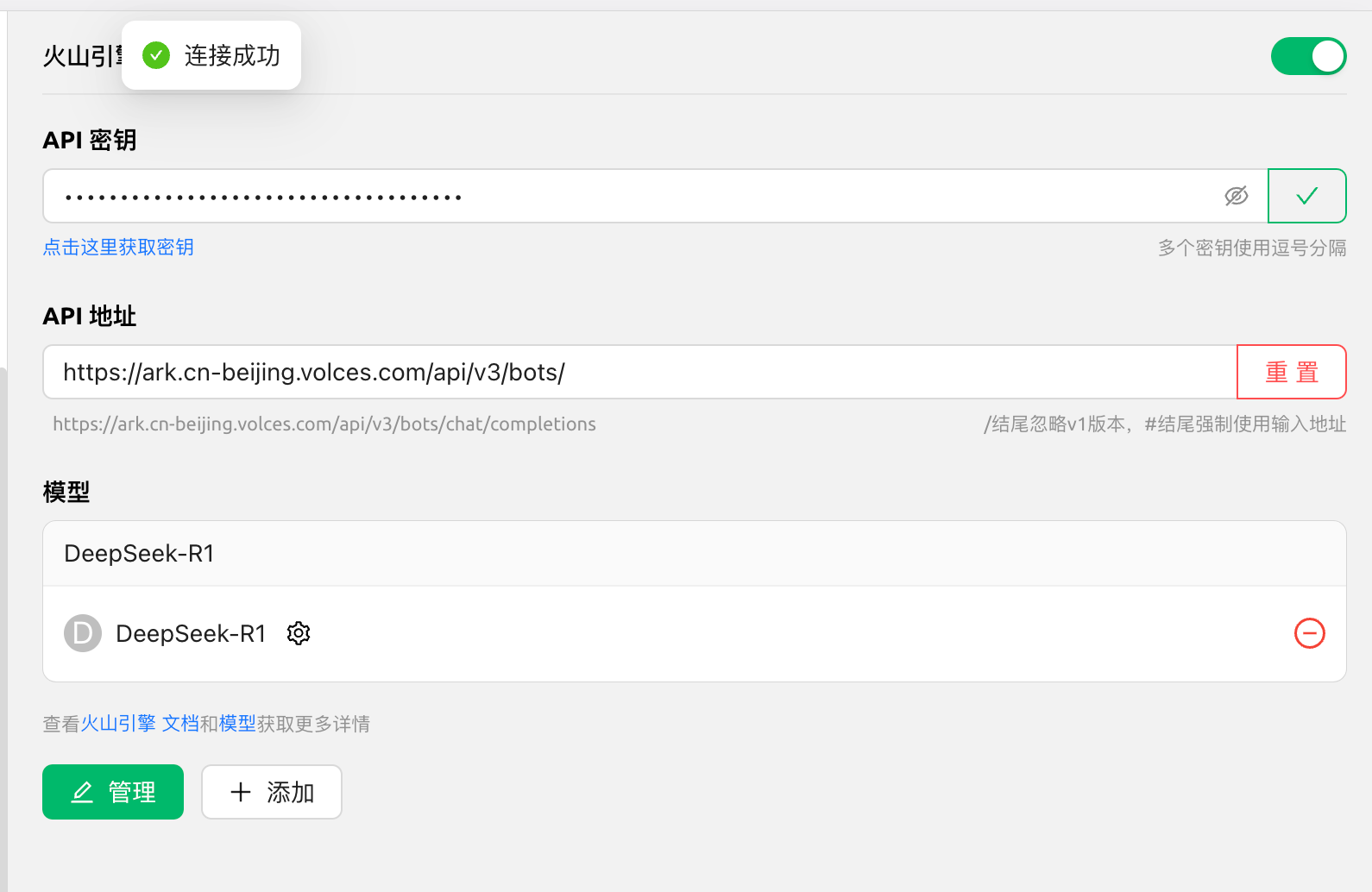

这次仍然以 Cherry Studio 为例(可以在我提供的大礼包里查看)

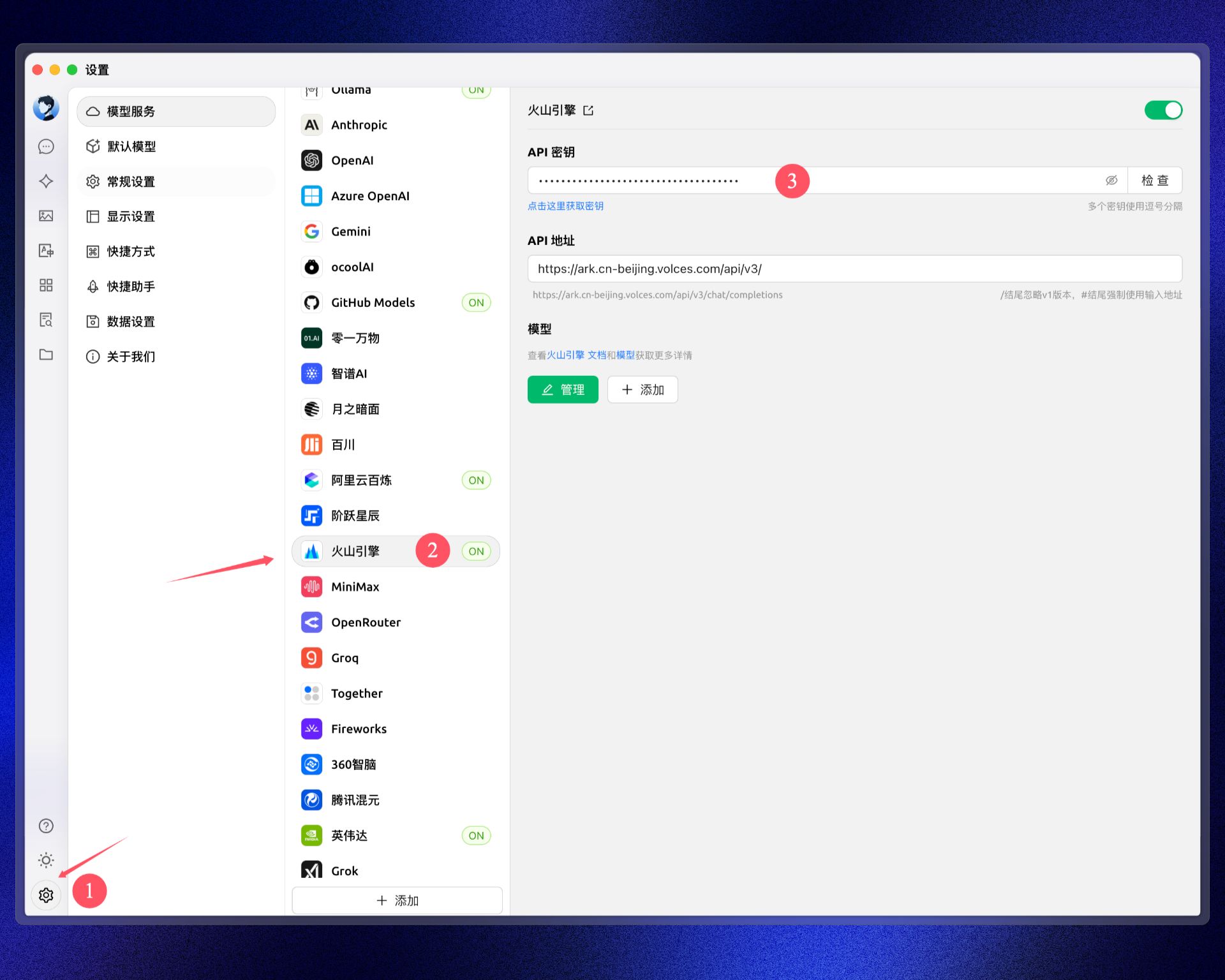

把复制的 API Key 填入 Cherry Studio

具体步骤为 点击左下角设置–找到火山引擎–把 API Key 填进对应地址

(如果使用的是老版本就选择豆包)

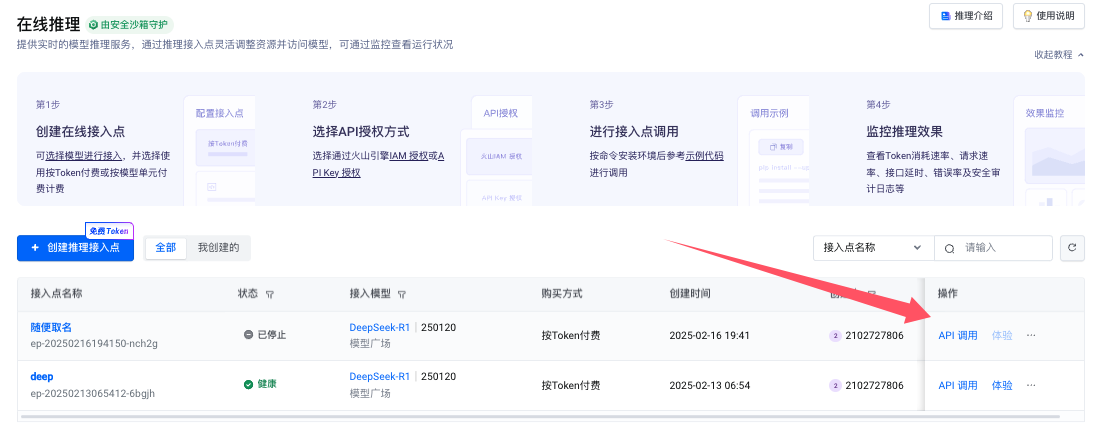

回到火山引擎中,点击左侧的在线推理,创建一个在线推理点

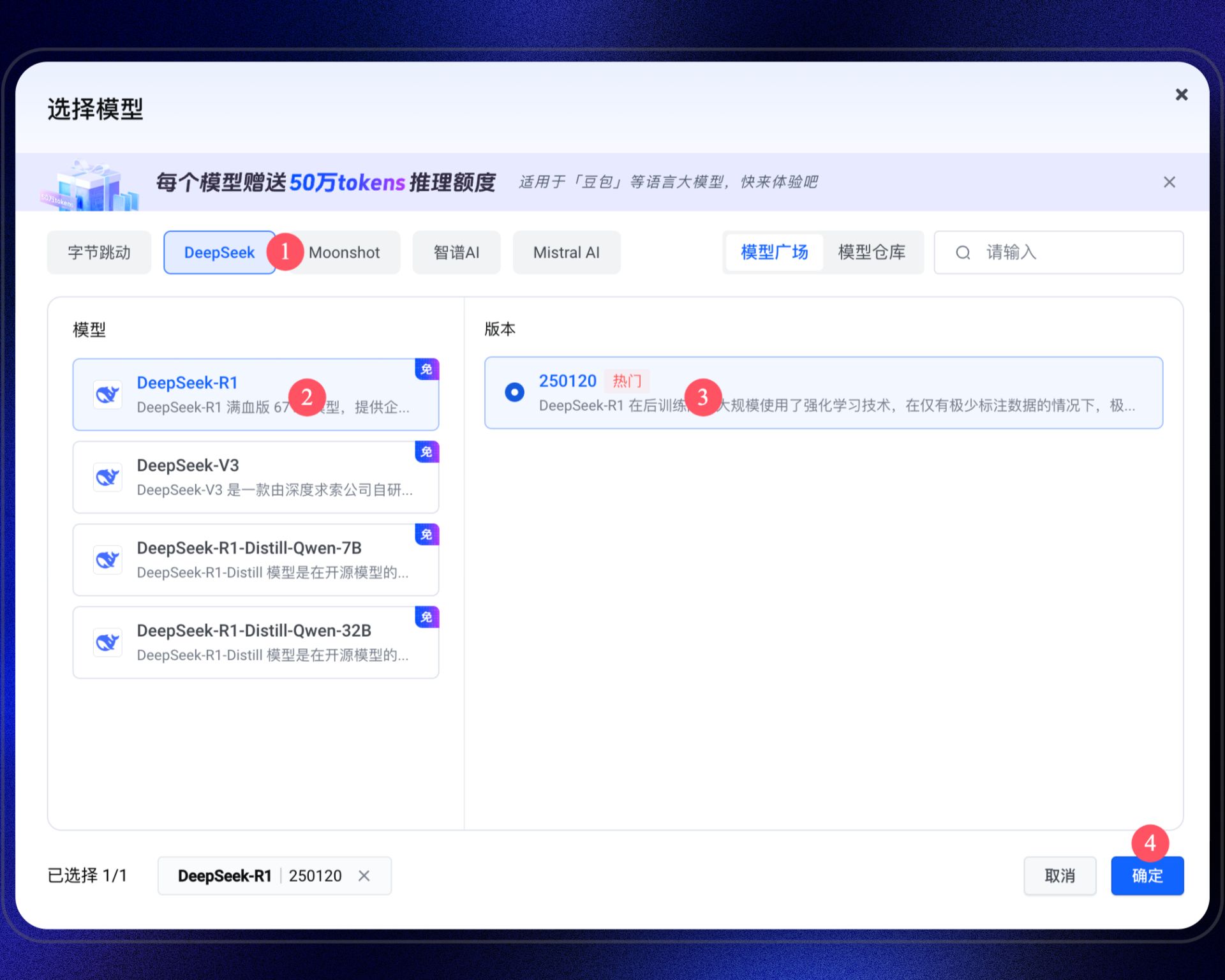

随便命名一下,点击添加模型

然后选择 DeepSeek-R1 ,勾选左边的模型版本,最后点确定

点击确定接入

我们从在线推理列表中,找到我们刚创建的那个,点右边的 API 调用

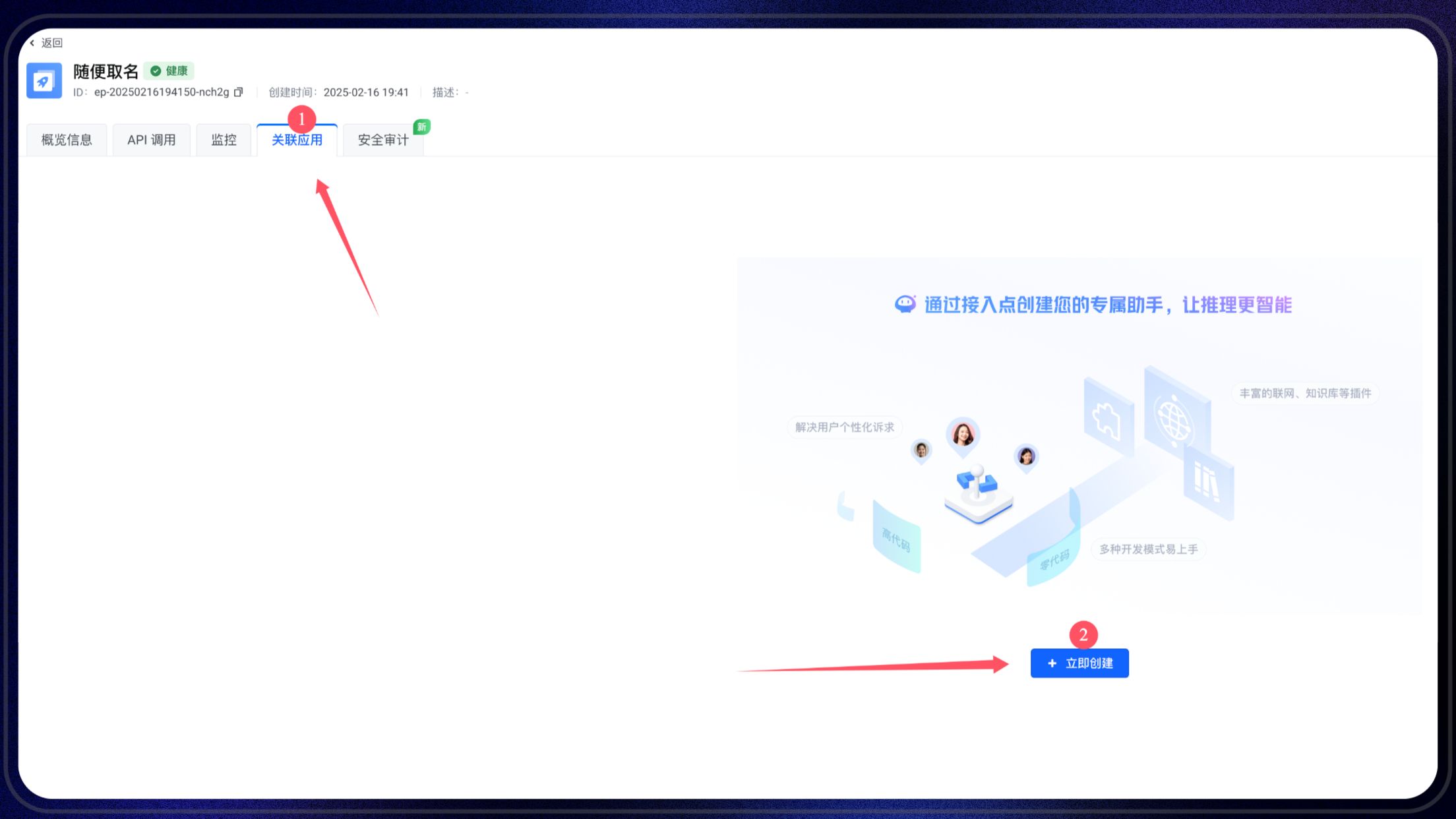

在上方点击关联应用,去创建一个联网应用

选择零代码创建一个单人或多人聊天的 APP

同样的随便去 命名

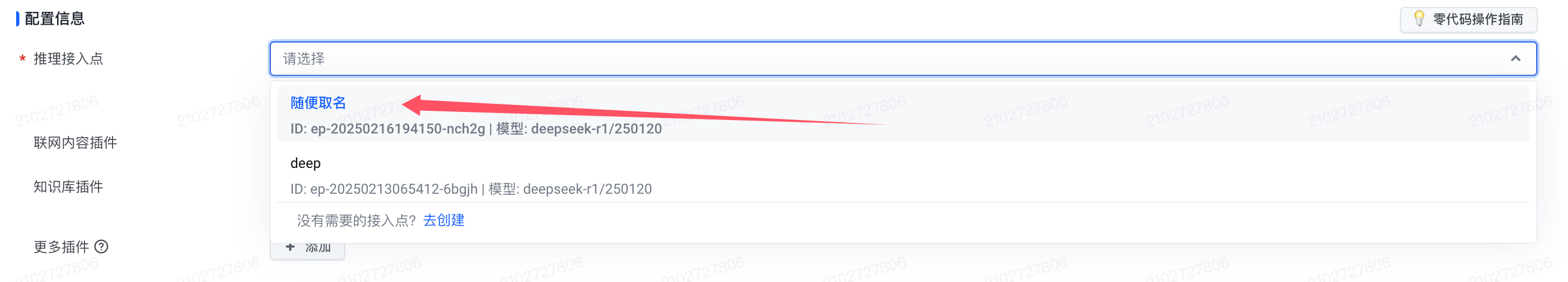

在推理接入点这里选择我们创建的那个接入点

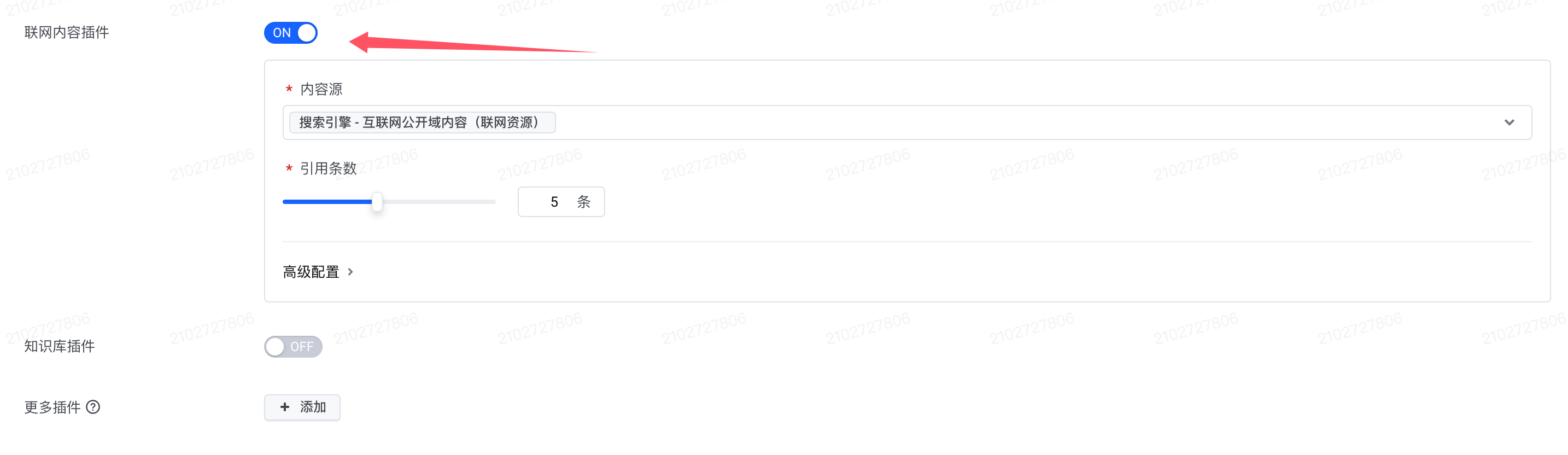

打开联网内容插件,第一次使用点击的时候会提示开通搜索包,目前免费20000次

设置完毕后,点击右上角的发布应用

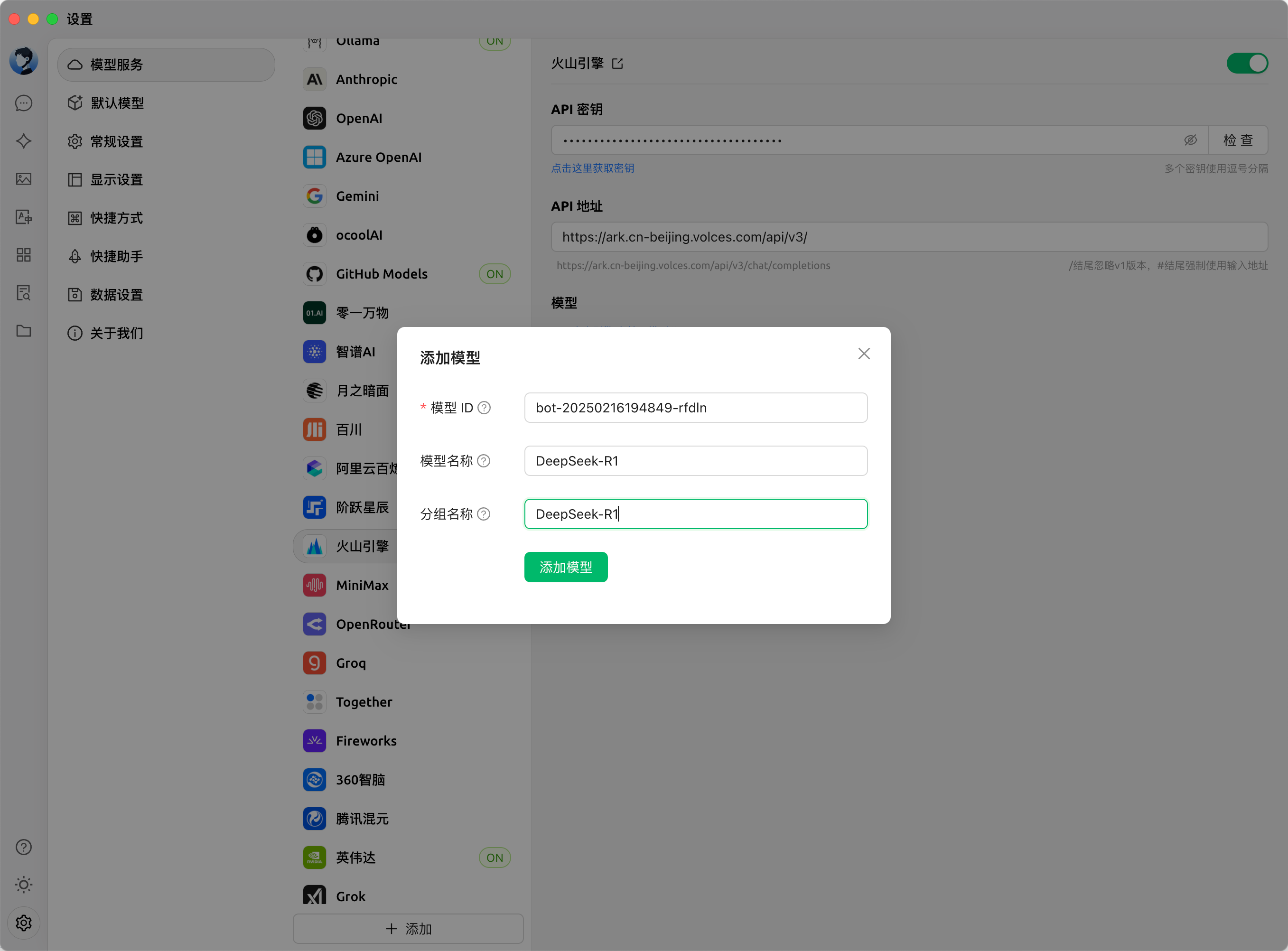

之后我们复制应用名称下面的应用ID

回到 Cherry Studio 中,点击添加模型(这里建议把之前的模型删掉以免混乱)

把我们的应用ID粘贴到模型ID这里,然后下面两个填入模型名称:DeepSeek-R1,然后添加即可

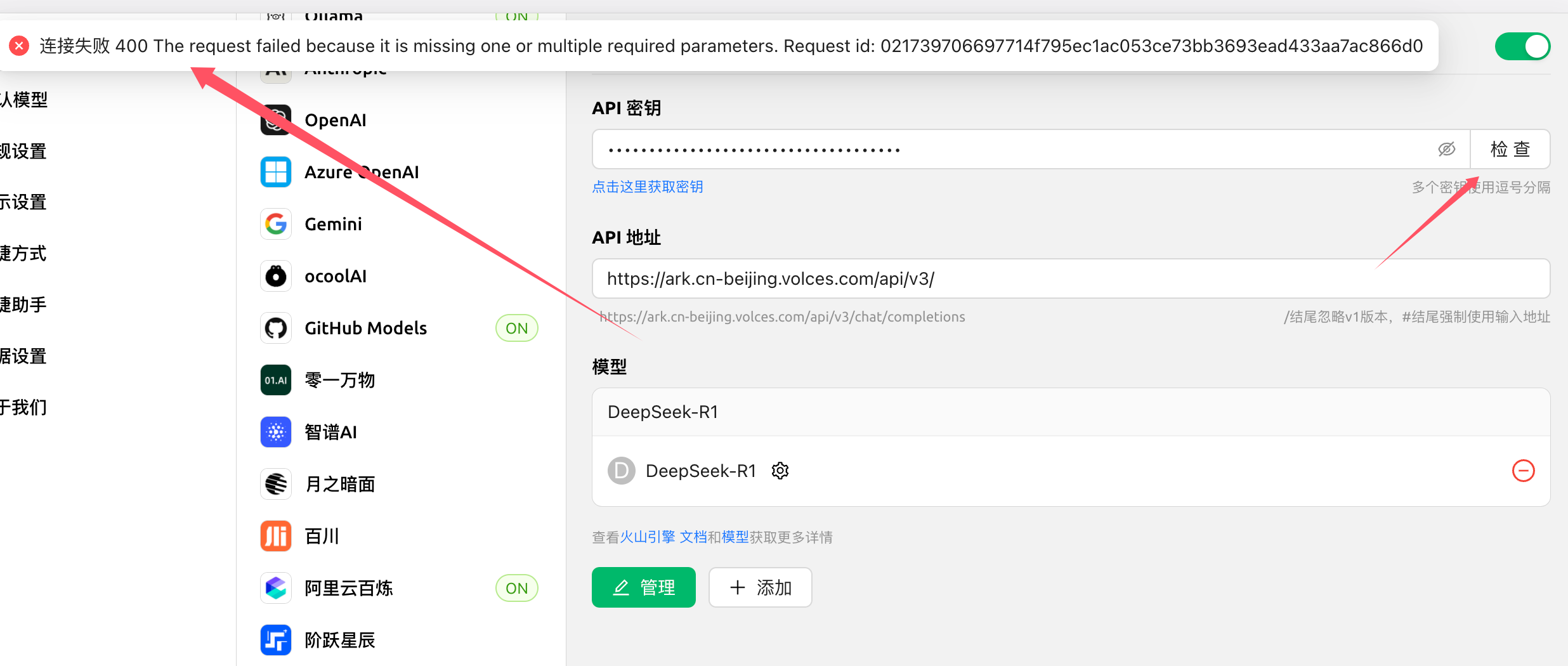

这时候直接去点击检查,会出现一个连接失败的错误 🙅 , 这是因为字节的应用和模型并不适用同一个接口地址

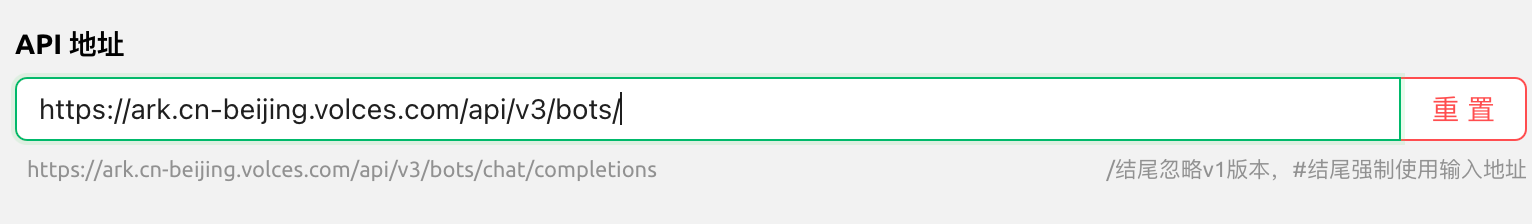

我们只需要在默认的API地址后面加上bots/,如果你使用的是其它客户端进行连接,那么它的完整版地址是:1

https://ark.cn-beijing.volces.com/api/v3/bots/chat/completions

然后我们再次进行测试连接

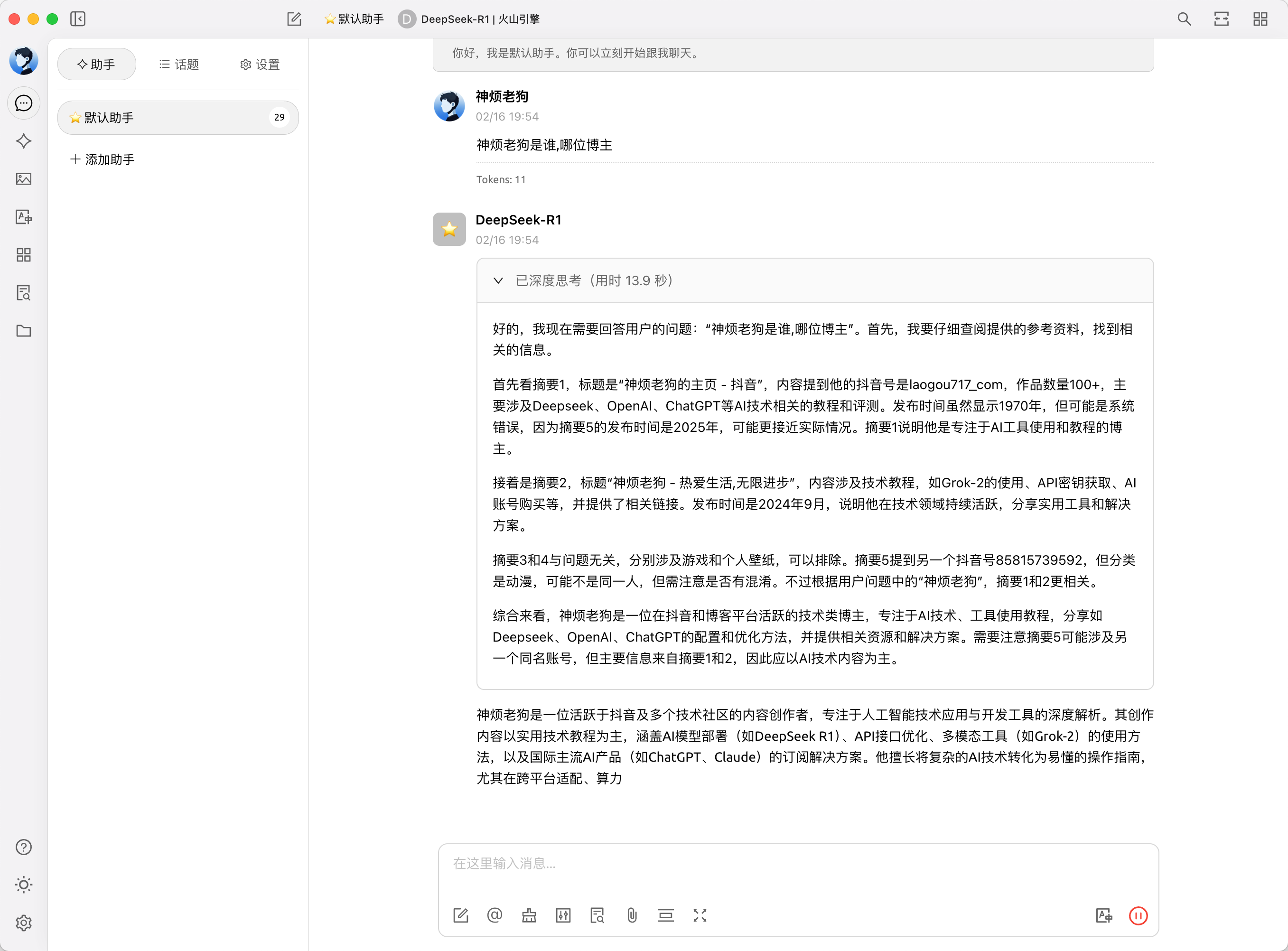

Cherry Studio 聊天测试

AnythingLLM (本地、API联网)

这是一个全栈应用程序,可以将任何文档、资源(如网址、音频、视频)或用户内容片段转换为上下文,以便任何大语言模型(LLM)在聊天期间参考使用。此应用程序允许您选择使用哪个LLM或支持数据库。适合初学者快速体验模型联网的效果。

2. page-assist 本地、API联网工具 浏览器扩展 (本地、API联网)

各类任务的侧边栏

支持视觉模型

本地AI模型的简约网页界面

网络搜索功能

在侧边栏与PDF进行对话

与文档对话(支持pdf、csv、txt、md、docx格式)

此外,还可参考其他开源项目和平台,根据个人需求选择合适的解决方案。

五、Docker 部署 WebUI 方案

OpenWebUI部署

1 | docker run -d -p 3000:8080 \ |

LobeChat部署

1.复制命令到终端

1 | docker run -d -p 3210:3210 -e OLLAMA_PROXY_URL=http://host.docker.internal:11434/v1 lobehub/lobe-chat |

LibreChat部署步骤(教程来自官网)

按照以下步骤使用默认配置部署 LibreChat:

1.克隆存储库

1 | git clone https://github.com/danny-avila/LibreChat.git |

2.导航到 LibreChat 目录

1 | cd LibreChat |

3.从 .env.example 创建 .env 文件

1 | cp .env.example .env |

注意: 如果您使用的是 Windows,则可能需要使用copy而不是cp。

4.启动 LibreChat

1 | docker compose up -d |

5.访问 LibreChat!

1 | 访问http://localhost:3080/ |

6.更新 LibreChat

注意:根据您的环境权限,您可能需要在命令前加上 sudo。

- 停止正在运行的容器

docker compose down - 提取最新的项目变更

git pull - 拉取最新的 LibreChat 镜像

docker compose pull - 启动 LibreChat

docker compose up

六、一键部署个人网站

LobeChat一键部署

通过以下按钮即可快速启动一个自己的聊天网站。

LibreChat一键部署

七、其他常见问题与温馨提示

硅基流动问题

免费用户在使用 Deepseek 服务时可能会受到访问速度限制,付费用户体验较好。对于大部分用户来说,如果出现聊天速度缓慢的情况,可以考虑直接使用 API 替代方案。GitHubmodels API 接入报错

国内网络环境不稳定是常见原因,建议尝试更换优质节点,或选择其他快速 API。博客访问卡顿

如果博客加载缓慢,可以直接使用备用链接或下载本地资源。声音问题

关于视频中声音大小的问题,由于录制时连续作业且个人嗓子状态原因,可能出现声音不理想的情况。建议大家以内容为主,多关注技术细节。

总结

本期文章从多个角度详细解答了 Deepseek 官网卡顿、模型联网、API 接入及 Docker 部署 UI 等问题。希望这篇文章能够帮助到正在寻找解决方案的新手朋友,也欢迎各位留言讨论、提出建议。

对于 Deepseek R1 模型及其联网模块,关键在于理解模型本身与平台功能的区分;而选择优质 API 或平台,则能让体验更加顺畅。

感谢各位的阅读与支持,祝大家在使用 Deepseek 以及其他 AI 工具的过程中都能事半功倍!

如果您有任何疑问或反馈,欢迎在评论区留言讨论。

- 感谢您的赞赏